Actualité scientifique

Besoin de trouver une idée ? Laissez votre esprit errer…

Il y a quelques temps, nous mettions en avant le fait qu’un esprit vagabond pouvait être fécond (voir l’article). En conviant « l’effet douche », des hommes qui plient du linge, une brique, un trombone et un orgasme simulé par Meg Ryan, la présente recherche tente de parvenir à la même conclusion. Les meilleures idées surgissent-elles plus facilement lorsque nous sommes engagés dans une tâche « anodine » ?

Il y a quelques temps, nous mettions en avant le fait qu’un esprit vagabond pouvait être fécond (voir l’article). En conviant « l’effet douche », des hommes qui plient du linge, une brique, un trombone et un orgasme simulé par Meg Ryan, la présente recherche tente de parvenir à la même conclusion. Les meilleures idées surgissent-elles plus facilement lorsque nous sommes engagés dans une tâche « anodine » ?Peut-être cela vous est-il déjà arrivé : vous êtes en promenade, en train de faire vos vitres ou sous la douche, et là une idée surgit dans votre esprit ! ...

Le syndrome de Tournesol

Le Billet du Neurologue Dr Bernard CROISILE

Le Billet du Neurologue Dr Bernard CROISILEEn 2020, l’Agence Nationale de Sécurité Sanitaire s’est inquiétée du niveau d’inactivité physique observé chez deux-tiers des jeunes de 11 ans à 17 ans, en grande partie lié au temps d’exposition devant les écrans numériques. La sédentarité est dangereuse pour la capacité cardio-respiratoire des adolescents… et des plus âgés. Le conseil traditionnel est de pratiquer du sport.

Or, le sport peut se révéler néfaste. Le président Barack Obama avait même déclaré « Je suis un grand fan de football {américain}, mais si j’avais un fils, je ne le laisserais pas devenir joueur de foot ...

La forêt : un anti-stress naturel ?

Vivre en ville serait plus stressant que d’habiter en pleine nature. C’est un constat couramment admis et un nombre croissant d’études (le plus souvent empiriques) mettent en avant les potentiels bienfaits physiques et psychologiques des espaces verts. Dans la présente recherche menée en Allemagne, les scientifiques avaient pour objectif de démontrer si une promenade en forêt était réellement plus déstressante qu’une balade en ville.

Vivre en ville serait plus stressant que d’habiter en pleine nature. C’est un constat couramment admis et un nombre croissant d’études (le plus souvent empiriques) mettent en avant les potentiels bienfaits physiques et psychologiques des espaces verts. Dans la présente recherche menée en Allemagne, les scientifiques avaient pour objectif de démontrer si une promenade en forêt était réellement plus déstressante qu’une balade en ville. Plus de la moitié de la population mondiale réside actuellement dans les villes. De nombreuses études ont établi que le mode de vie urbain avait une incidence non négligeable sur l’anxiété et les troubles de l’humeur. En ...

Tout est relatif

Le Billet du Neurologue Dr Bernard CROISILE

Le Billet du Neurologue Dr Bernard CROISILEJe ne sais pas quand vous lirez ce texte, mais il fut écrit cet été. Une des caractéristiques de l’été est de boire des apéros avec ses amis (en toute modération bien sûr, et sans oublier les cinq fruits et légumes quotidiens, ni les 60 minutes de marche) tout en résolvant les problèmes de l’Univers avec un brio à faire pâlir la plupart des dirigeants mondiaux ! L’été est aussi propice aux lectures, ce qui m’a permis de parcourir un livre sur les maisons d’écrivains américains dans lequel j’ai trouvé cette jolie citation d’Edith Wharton (1862-1937) « J’étais une ratée à Boston, parce ...

Perte d’audition liée à l’âge : une fatalité ?

Qu’est-ce que la presbyacousie et quelles sont les conséquences sur mon cerveau ?

Qu’est-ce que la presbyacousie et quelles sont les conséquences sur mon cerveau ?D’après un rapport de l’Organisation Mondiale de la Santé, plus de 30% des personnes de plus de 65 ans ont un déficit d’audition. La cause principale de perte d’audition chez les personnes âgées est appelée presbyacousie. Celle-ci est due à un vieillissement et une perte des cellules spécialisées dans l’audition situées au niveau de l’oreille, les cellules ciliées, à une diminution progressive de souplesse des muscles de l’oreille, ainsi qu’à une dégénérescence des neurones reliés aux cellules ciliées. ...

Les oreilles entendent, le cerveau comprend

L’audition, comment ça marche ?

Lorsqu’un son arrive au niveau des oreilles, il passe par l’oreille externe, l’oreille moyenne et arrive au niveau de l’oreille interne où se trouve la cochlée. C’est ici que le signal auditif est filtré selon les différentes fréquences qui le composent.

Au centre de la cochlée, au niveau de la membrane basilaire, se trouve l’organe de Corti qui rassemble des milliers de cellules ciliées. Ce sont elles qui vont transformer le signal acoustique en signal neuronal.

Après qu’un son ai été perçu par l’oreille, un signal est envoyé au cerveau via le nerf auditif. Ce signal arrive alors dans une ...

Promenons-nous dans les bois…

Les potentiels bienfaits physiques et psychologiques des espaces verts font l’objet de nombreuses études, mais celles qui s’intéressent au rôle de ces derniers dans le développement cognitif le sont nettement moins. Nous avons d’ailleurs déjà mis en lumière quelques études sur les effets possibles des espaces verts, notamment sur l’amélioration de l’attention chez les jeunes enfants ou encore sur le temps que nous ...

Les potentiels bienfaits physiques et psychologiques des espaces verts font l’objet de nombreuses études, mais celles qui s’intéressent au rôle de ces derniers dans le développement cognitif le sont nettement moins. Nous avons d’ailleurs déjà mis en lumière quelques études sur les effets possibles des espaces verts, notamment sur l’amélioration de l’attention chez les jeunes enfants ou encore sur le temps que nous ... Et si l’empathie améliorait notre créativité ?

Les compétences dites « non académiques » sont de plus en plus recherchées, sollicitées et encouragées en milieu professionnel. Parmi elles, les compétences sociales et émotionnelles. Cette prise de conscience n’est d’ailleurs pas récente, puisque comme le rappellent les auteurs de la présente étude, John Dewey, psychologue et philosophe américain majeur de la première partie du XXème siècle, avait compris très tôt l’intérêt de les enseigner : « Il n'y a pas d'éducation lorsque les idées et les connaissances ne se traduisent pas en émotion, intérêt et volonté. » Presque un siècle plus tard, l’équipe de recherche de l’Université de Cambridge ...

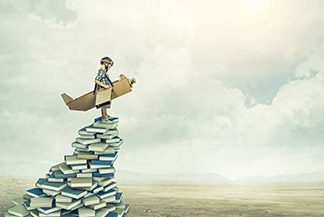

Les compétences dites « non académiques » sont de plus en plus recherchées, sollicitées et encouragées en milieu professionnel. Parmi elles, les compétences sociales et émotionnelles. Cette prise de conscience n’est d’ailleurs pas récente, puisque comme le rappellent les auteurs de la présente étude, John Dewey, psychologue et philosophe américain majeur de la première partie du XXème siècle, avait compris très tôt l’intérêt de les enseigner : « Il n'y a pas d'éducation lorsque les idées et les connaissances ne se traduisent pas en émotion, intérêt et volonté. » Presque un siècle plus tard, l’équipe de recherche de l’Université de Cambridge ... De l’intérêt des échecs et des erreurs…

« Si tu peux voir détruit l’ouvrage de ta vie

« Si tu peux voir détruit l’ouvrage de ta vie Et sans dire un seul mot te mettre à rebâtir, »

C’est ainsi que débute le poème If de Rudyard Kipling (1865-1936), adapté en français par André Maurois sous le titre « Tu seras un homme, mon fils. » Mais plus personne ne lit Rudyard Kipling. Les jeunes pensent que c’est Walt Disney qui a écrit le Livre de la Jungle. Les moins jeunes craignent de donner l’impression de soutenir sa vision colonialiste d’un empire britannique ayant régné sur le quart du monde, sans oublier que le sens du devoir de Kipling et son culte de l’éducation morale paraissent politiquement « incorrects ...

La loi du fond du tiroir

Dans La Communauté de l’Anneau, 1er volume du Seigneur des Anneaux, J.R.R. Tolkien fait écrire par le magicien Gandalf au Hobbit Frodon : « J’espère que Poiredebeurré enverra ceci promptement. C’est un digne homme, mais sa mémoire ressemble à un débarras : ce dont on a besoin est toujours enfoui. » Pour ceux qui ne le savent pas, Prosper Poiredebeurré est l’aubergiste du Poney Fringant à Bree. Mon propos d’aujourd’hui ne sera pas celui de sa mémoire mais celui du débarras, car il concerne cette situation exaspérante que j’appellerai La loi du fond du tiroir: ce qu’on cherche est TOUJOURS au fond du tiroir (ou du débarras pour ...

Dans La Communauté de l’Anneau, 1er volume du Seigneur des Anneaux, J.R.R. Tolkien fait écrire par le magicien Gandalf au Hobbit Frodon : « J’espère que Poiredebeurré enverra ceci promptement. C’est un digne homme, mais sa mémoire ressemble à un débarras : ce dont on a besoin est toujours enfoui. » Pour ceux qui ne le savent pas, Prosper Poiredebeurré est l’aubergiste du Poney Fringant à Bree. Mon propos d’aujourd’hui ne sera pas celui de sa mémoire mais celui du débarras, car il concerne cette situation exaspérante que j’appellerai La loi du fond du tiroir: ce qu’on cherche est TOUJOURS au fond du tiroir (ou du débarras pour ...